NVIDIA:GPU将取代CPU继续保持摩尔定律成长

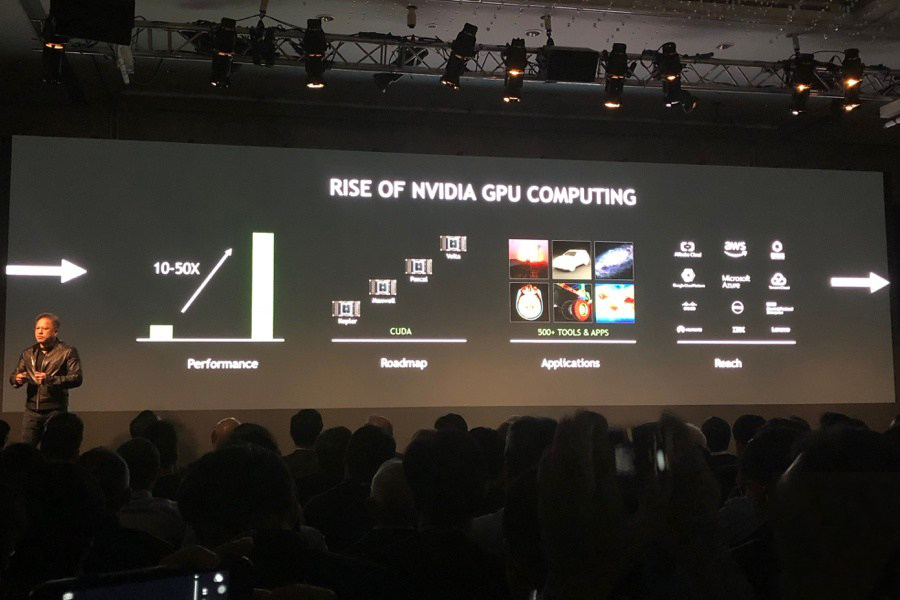

在此次GTC活动中,NVIDIA黄仁勋再次强调因类神经网络为基础的深度学习运算模式兴起,进而凸显GPU运算能力更高特性,并且延续性能成长幅度趋缓多年的CPU在摩尔定律演进,成为目前人工智能技术主流演算方式,借此应用在各类技术领域发展。

就黄仁勋看法认为,电脑运算依然需要CPU进行基础运算与指令集处理,但在更大数据分析则需要借助GPU运算能力,因此目前主流人工智能技术均以CPU+GPU的组合为运算基础,此外也能通过更大运算性能驱动不同电脑使用模式,例如通过虚拟现实互动共同作的Holodeck,便让使用者能通过高解析虚拟现实图像在线协同作业。

目前投入人工智能的创新产业已经在过去5年内成长10倍,总计约带来66亿美元规模产值,同时关于深度学习的论文内容在过去3年也成长10倍,并且有超过3000个论文内容被提出。通过深度学习模式,目前已经可通过GPU加速方式实现3D图像中的即时自然光影追迹、人脸表情与口语同步、动画人物动作自动表现、确保图像中的物件相对距离,或是让机器手臂判断、移动正确物件等过往难以实现技术。

而为了进一步协助人工智能技术应用发展,黄仁勋宣布将采用Volta显示构架的DGX-1V,通过排名全球前25名内的超级电脑运算能力协助带动智能制造、物联网、智能城市、智能医疗等技术成长,并且协助更多创新团队通过人工智能技术推出更多创新服务。

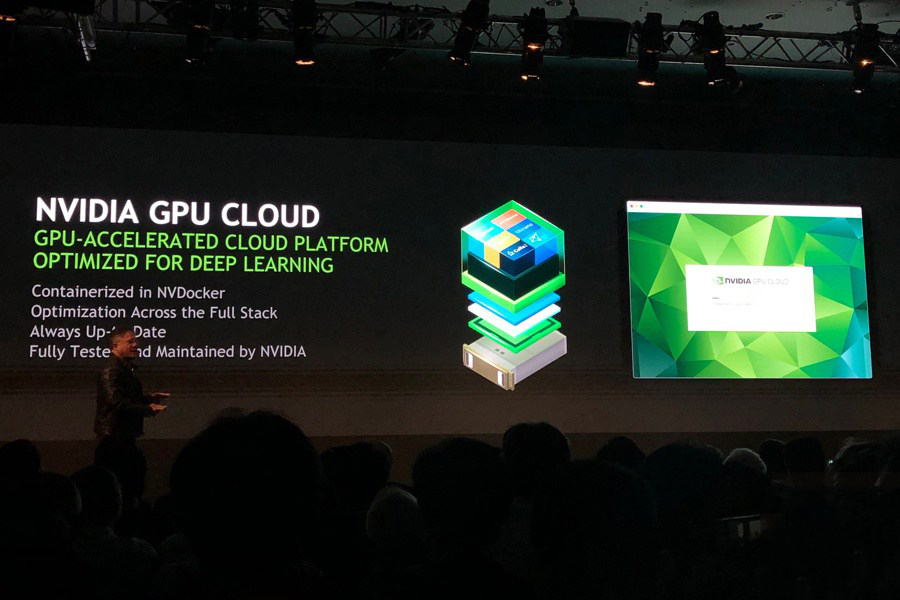

同时,借助于NVIDIA今年在GTC 2017提出的GPU Cloud服务,将可让企业、创新团队通过云端协作方式取得更大运算能力,借此实现各类深度学习等训练需求,进而可应用在人工智能建立、电脑视觉应用、自动驾驶发展,或是对应越来越多的物联网设备使用需求,并且持续带动更多类神经网络模型生成。

针对学习模型运算部分,除了对应市场主流学习模型设计,NVIDIA日前也宣布推出学习模型加速器TensorRT 3,借此让深度学习效率大幅提升,进而可在运算设备成本做更明显节省,例如原本160组CPU以每秒分析4万5000张照片的演算需求,通过配置8张Tesla V100的单组NVIDIA HGX超级电脑即可达成相同运算性能,但在占用体积、使用电耗却明显不同,几乎仅需占用原本1/4体积、1/20电力损耗,甚至仅需原本1/6左右的成本支出。

黄仁勋强调,通过GPU加速带动云端服务器运算性能规模,将可持续推动超级电脑、云计算应用服务、公有云等成长,甚至可进一步带动整体产业走向全新改革。

-

1想在《明日方舟:终末地》里畅快打灰需要准备些什么?

-

2AMD 锐龙9 9955HX与英特尔酷睿Ultra 9 275HX,谁才是玩家的“帧香”选择?

-

3华硕ROG B850迷你吹雪主板双12开售 纯白小钢炮

-

4把240p马赛克变4k的“NVIDIA神力”,发展到什么地步了?

-

5AMD 锐龙7 9850X3D首发评测:站在巨人的肩膀上更快更强

-

6索泰RTX 5080整机免费送!「无索不AI 桌搭大赛」正式开启

-

7R7000P和Y7000P怎么选?联想拯救者Y7000P 2025为何是更优选择?

-

8技嘉Z890 AORUS PRO ICE电竞冰雕评测:200S Boost模式加持,285K性能飞升

-

9“核力满满 帧帧制霸” AMD帧香电竞嘉年华南京终极一站完美谢幕,硬核性能引爆玩家狂欢!

-

10海信发布旗舰显示器GX:三大电视同源技术,新品首发价4399元

玩家点评 (0人参与,0条评论)

热门评论

全部评论